少し前にAIによって画像生成を行うStable Diffusion関連のソフトウェアでStabilityMatrixやNMKD Stable Diffusion GUIの記事を掲載しましたが、やはり最終的に作りたくなってくるのは動画だと思います。現在ではオンラインサービスを利用して短時間のAI動画を作成する事も可能なようですが、無料で作成出来る範囲には限界がある他に不健全な動画を作成するには制限もあります。勿論オンラインサービスの場合、自身のPCの性能や構成に影響されずに作成出来るメリットもあるのですが、自分の作りたい物を制限されず自由に作るにはやはりローカルでソフトを動かして作成するしか方法はありません。

そんな不健全な動画の作成もローカルで比較的簡単に出来てしまうのが今回記事にするFramePackです。FramePackはStable DiffusionのWeb UI Forge版の開発で知られるlllyasviel氏によって開発されたオープンソースの動画生成AIソフトで、1枚の画像を元に動画を生成する事が出来ます。最低6GBのVRAMのビデオカードでも動作させる事が出来るのが特徴となっていますが、最近お手頃価格になってきたRTX 3060程度のビデオカードだと5秒の動画を生成するのに約30分程掛かり、本格的な動画コンテンツの製作という点では実用的とは言えません。もっと高性能なビデオカードを使用されているユーザーはそれなりに遊べるとは思いますが、今回は実用性は無視して形式上動作させる事を目的にFramePackを使用した経験を記事にします。

FramePackの対応OSについての詳細な情報はありませんが、Windows 11で動作確認している他、Linuxにも対応しています。動作要件として使用出来るのはNvidiaのGPUのみでVRAM 6GB以上のRTX 30, 40, 50シリーズが推奨されていますが、20シリーズの他にGTX 10シリーズでも動作するという情報があります。メモリやCPUに関する推奨環境の記載は見当たりませんが、起動中はメモリを50GB以上消費するので殆どの環境でストレージの領域を利用する仮想メモリを使用する事になります。

FramePackのダウンロードとインストール

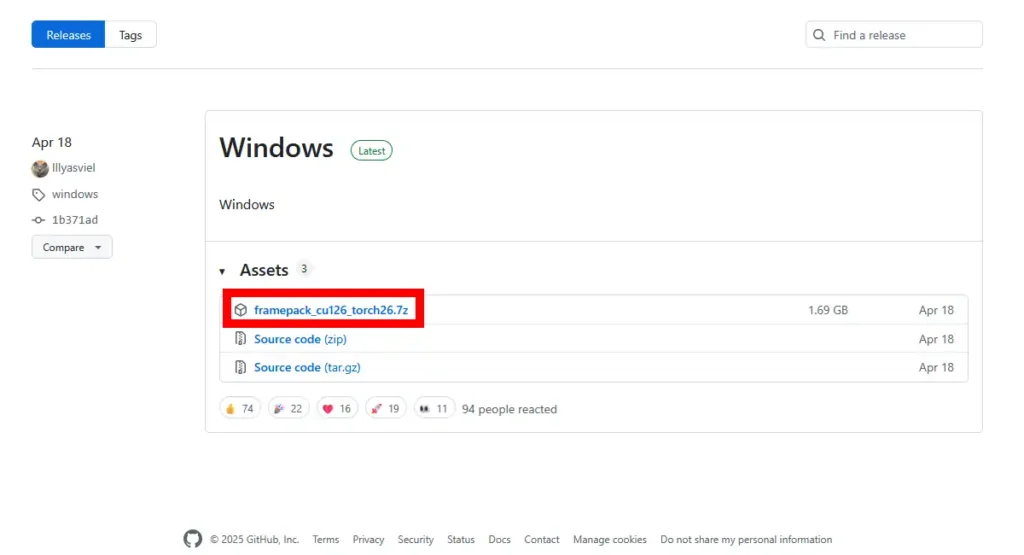

FramePackはGitHubで公開されています。Releasesのページからダウンロード出来るので、ダウンロード後に圧縮ファイルを展開して任意の場所に配置して下さい。

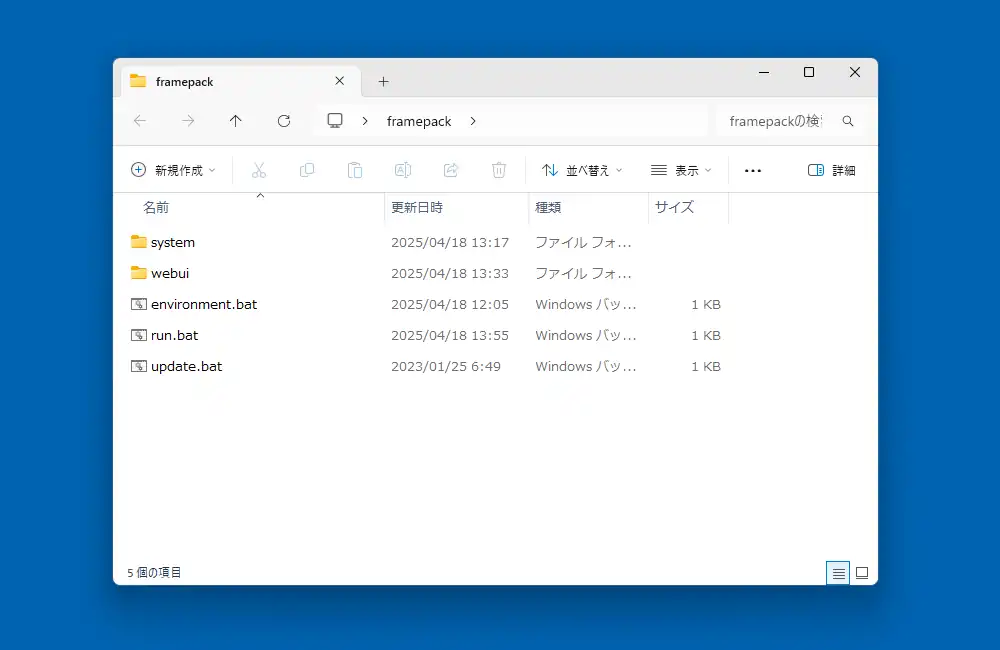

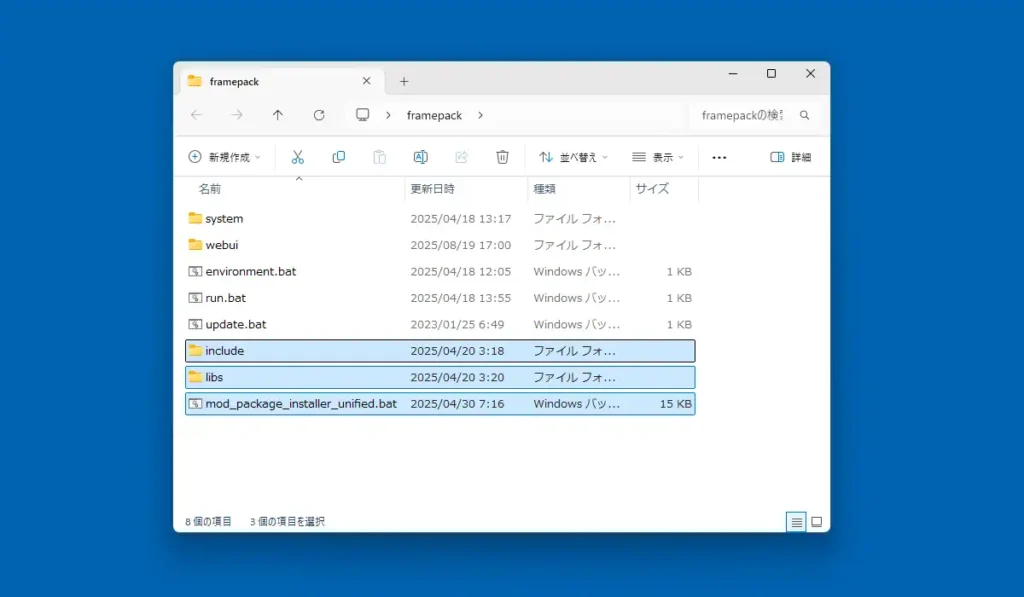

FramePackは以下のようなファイルとフォルダで構成されていますが、まずは「update.bat」をダブルクリックで実行してアップデートを確認。コマンドプロンプトが起動しアップデート実行後に「続行するには…」と表示されたら完了です。

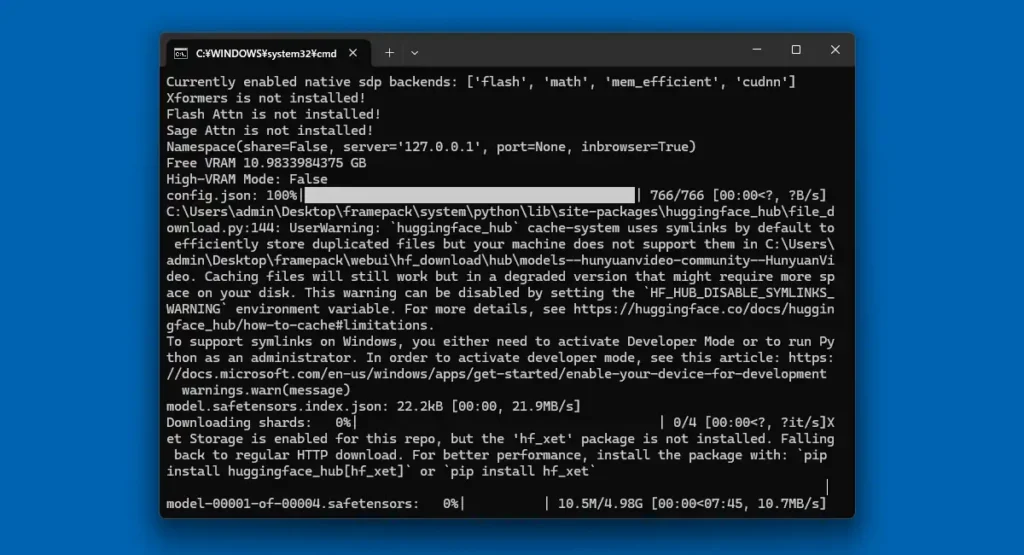

「run.bat」をダブルクリックで実行すると動作に必要な各種ファイルのダウンロードとインストールが実行されますが、筆者の環境では全ファイルのダウンロード完了後に約46GBの容量となりました。また、完了するまでに約1時間10分掛かったので時間に余裕のある時に行って下さい。

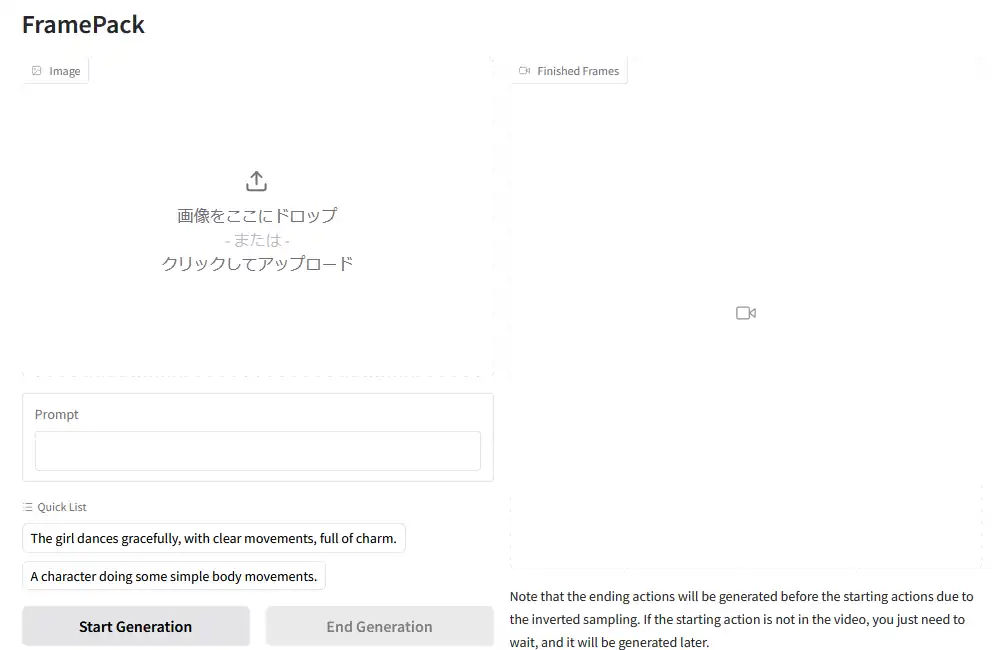

ダウンロードとインストールが全て完了すると自動でWebブラウザ内にFramePackの操作画面が起動します。終了する場合はコマンドプロンプトを閉じるだけ、再度起動する場合は「run.bat」を実行します。

FramePackの使い方

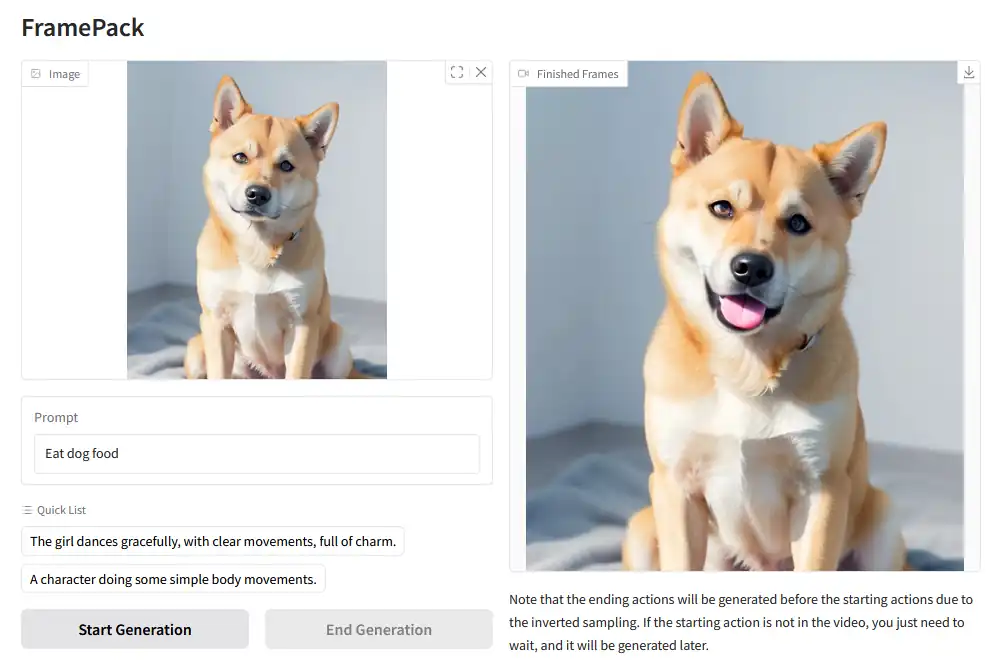

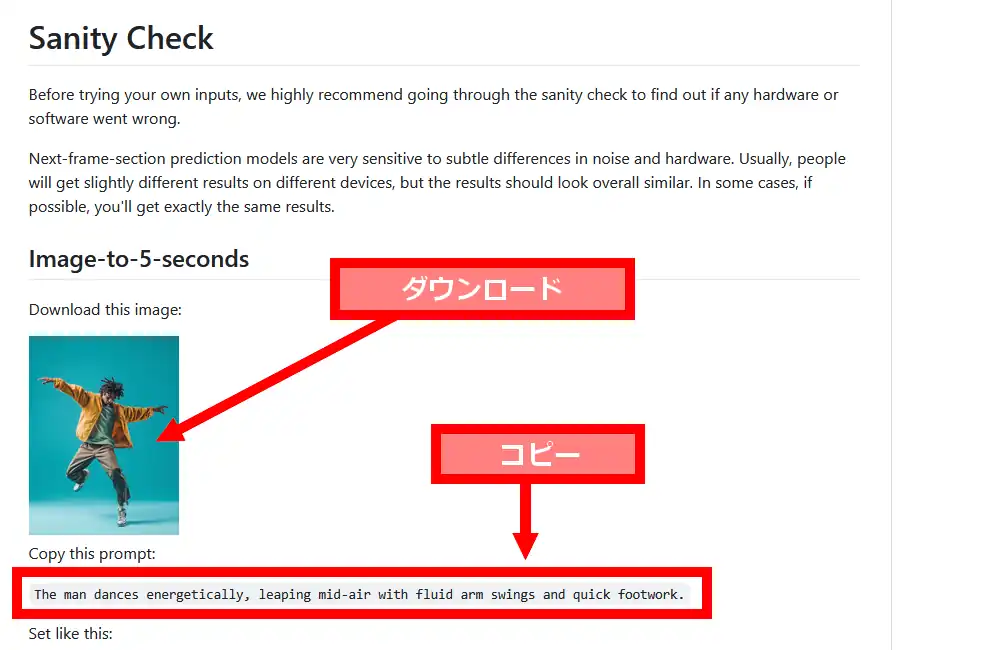

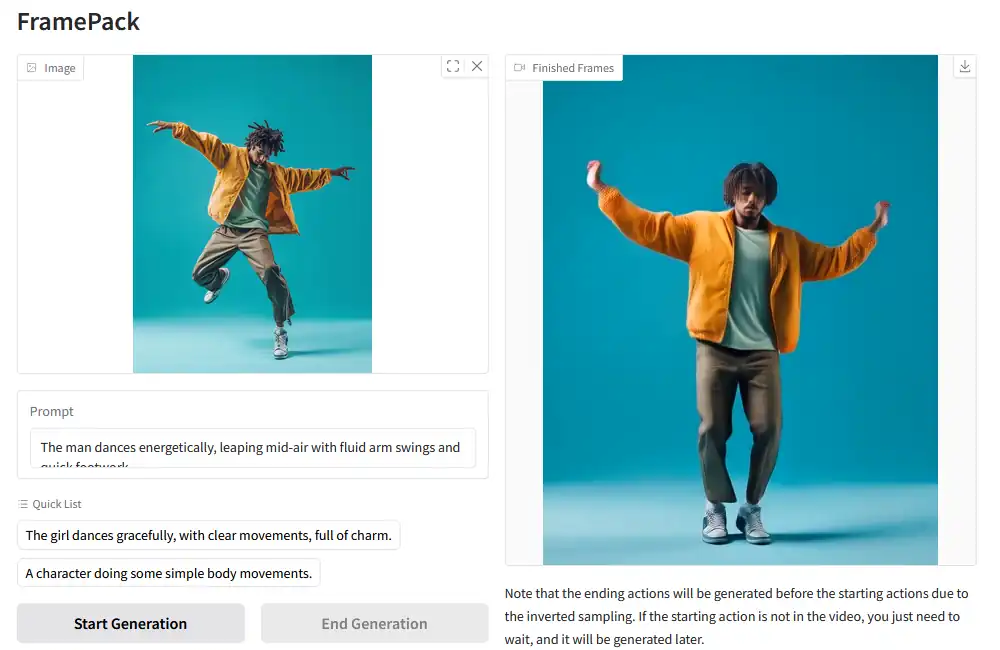

公式の記載に従ってSanity Check(健全性のチェック)を行います。GitHubのFramePackのページを下の方にスクロールすると踊っているような男性の画像があるので、この画像をダウンロードしておきます。ダウンロードした画像をFramePackの「画像をここにドロップ」欄にドロップして入力。更に下にある「Copy this prompt:」の記載のあるテキストをコピーしてFramePackの「Prompt」欄に貼り付けて入力。

「Use TeaCache」からチェックを外しておきます。それ以外は標準設定のままにしておき「Start Generation」で生成を実行。標準で5秒の動画が生成されるようになっていますが、筆者の環境では冒頭の方でも書いた通り完了するまでに約30分掛かりました。

最終的に動画が正常に生成されれば成功です。生成された動画はFramePackをインストールしているフォルダの「webui」から「outputs」フォルダと辿っていくと確認出来ます。ここには使用した画像や生成途中の動画といった複数のファイルが保存されますが、最後に保存されているのが完成動画となります。

正常動作が確認出来たら自身で用意した画像と作りたい動画の内容をプロンプト欄に入力して、オリジナル動画を生成してみて下さい。FramePackの画面内には幾つかの設定がありますが、設定内容や効果は以下のようになっています。

- Prompt

- 生成させたい動画の内容の指示。基本は英語で入力、複数ある場合はカンマで区切ります。

- Quick List

- プロンプトの用例。クリックするとプロンプト欄に入力されますが、使用する機会は無いと思います。

- Use TeaCache

- 有効化で動画生成を高速化する機能ですが、手や指の描画が悪化する傾向にあるようです。

- Seed

- 生成される動画に紐付いた数値。同じ数値を使う事で同じような動画を生成出来ます。Stable Diffusionと同じなら-1でランダム。

- Total Video Length (Seconds)

- 生成させる動画の長さを秒で指定。標準で5秒になっています。

- Steps

- 生成の過程でフレームを作り変えていく回数。標準で25となっており変更は非推奨となっています。

- Distilled CFG Scale

- プロンプトに対する忠実度。標準で10となっており、これも変更は非推奨となっています。

- GPU Inference Preserved Memory (GB) (larger means slower)

- 直訳だと推論用保持メモリとなりますが、推論時に使用するVRAMのメモリだと思われます。標準で6GBになっていますが、説明では大きい値を設定すると処理が遅くなるようです。但しOOM(Out Of Memory)でエラーが出る際には値を増やすと改善する可能性が有ります。

- MP4 Compression

- 動画の圧縮率。数値が小さいほど高画質になる分だけ出力されるファイルサイズが大きくなり、数値を大きくすると低画質になる分だけファイルサイズが小さくなります。

FramePackの動画生成を高速化

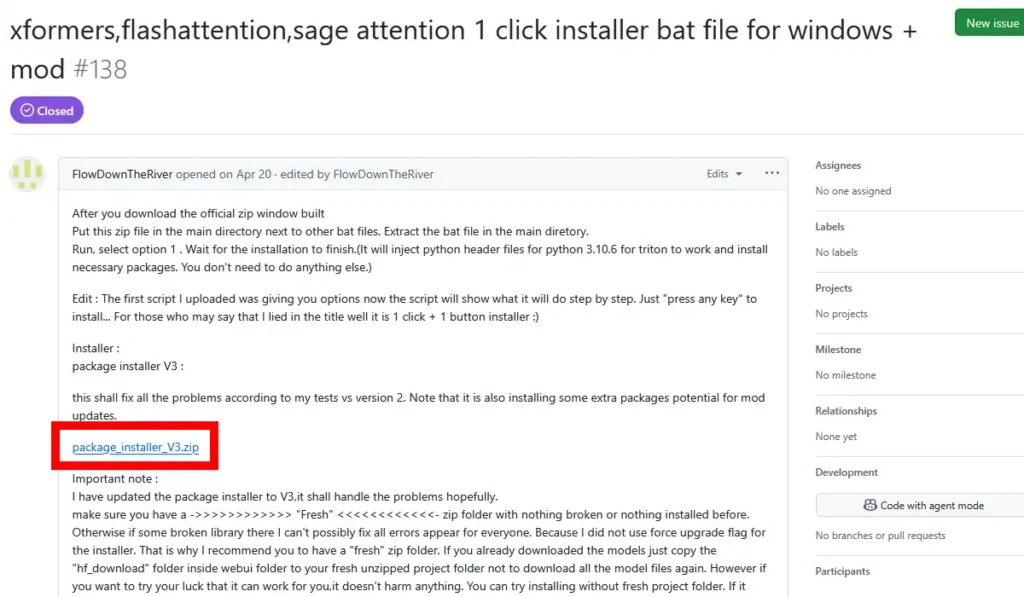

FramePackの動画生成の時間を短縮するプログラムがあるとの情報から筆者が試してみたのがpackage installerという物。これはxformers、flashattention、sage attentionを纏めて1クリックでインストール出来るプログラムで、FramePackのIssuesページで配布されています。

圧縮ファイル展開後、中身を全てFramePackフォルダ内にコピーしておきます。FramePackを終了している状態で「mod_package_installer_unified.bat」を実行。コマンドプロンプトが起動するので適当なキーを押してインストール実行。完了後、適当なキーを押して画面を閉じます。

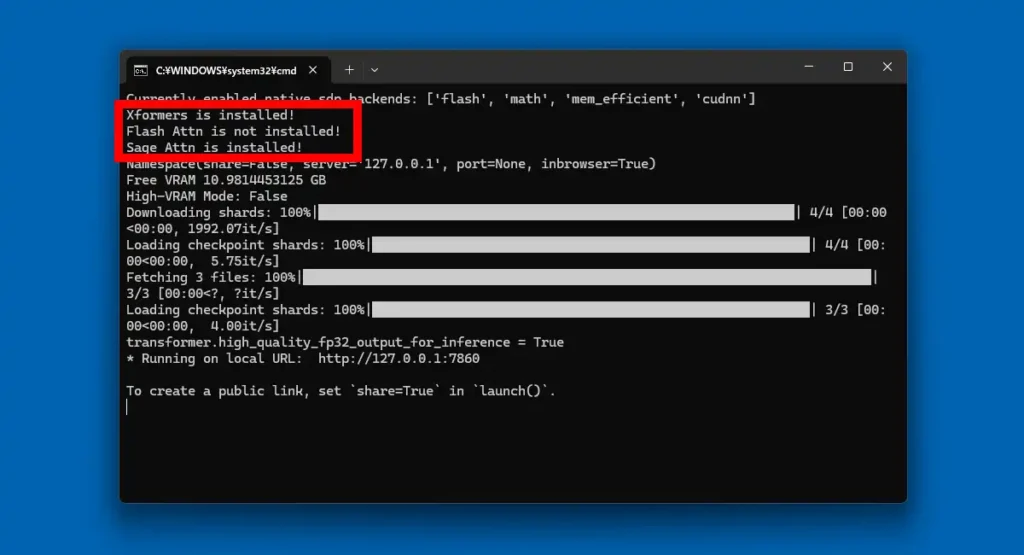

FramePackを起動する際にコマンドプロンプト内に表示される「Xformers」「Flash Attn」「Sage Attn」の3つが「installed!」となっていれば成功なのですが、見ての通り筆者の環境では「Flash Attn」が「not installed!」となり、色々と試してみたものの改善しませんでした。3つの内、2つインストールされていれば効果があるかもと思ったのですが、残念ながら生成速度は変わりませんでした。

因みにpackage installerの少し下にpackage uninstallerも配布されているので、それを使用してアンインストールする事が出来ます。

FramePack 備考

ローカルで動画生成AIを使用して動画を作れたという達成感は得られましたが、高速化のプログラムは上手くインストール出来ずモヤモヤした部分は残りました。しかし生成された動画の品質はかなり高く、画像から殆ど違和感の無い滑らかな動画が生成されたのには驚きました。ただ、RTX 3060の性能で動画生成AIを動かすのはかなり厳しい印象でした。また、起動しただけでもメモリ使用量が50GBを超え、生成中のピークでは66.3GBにまで達しました。CPU使用率は13%程度ではありましたが、それ以外のパーツにかなり負荷が掛かるので使用中に壊れないかと不安になります。

画像生成AIと同様、期待通りの物が生成されるかはガチャと呼ばれるように運次第ですが、画像と違い何度も生成し直すのは現実的では無いので、プロンプト以外に生成物を制御出来るような機能が必要だと思われます。この分野は日進月歩で進化していっているので、焦らなくてもその内もっと手軽で簡単に思い通りの動画を生成出来る時代が来るんじゃないかと期待しています。

コメント